研究人员发现人工智能聊天机器人存在一些人类偏见

随着人工智能越来越擅长为人类提供他们想要的东西,它也可能会更好地为恶意人类提供他们想要的东西。

阿尔弗雷德勒纳商业与经济学院管理信息系统教授、摩根大通高级研究员XiaoFang和运营管理副教授MingZhu与特拉华大学金融服务分析(FSAN)博士生毛敏嘉合作项目以及FSAN项目校友张宏哲和赵晓航研究员。

具体来说,他们感兴趣的是人工智能大型语言模型(例如开创性且流行的ChatGPT)是否会产生针对某些人群的有偏见的内容。

正如您可能已经猜到的那样,是的,他们做到了——而且甚至还没有达到临界点。这发生在相当于潜意识的人工智能中,对无辜的提示做出反应。但大多数人工智能模型也立即遵守了要求,使文字故意带有偏见或歧视。

这项研究开始于2023年1月,就在ChatGPT开始流行之后,每个人都开始怀疑人类文明(或至少是人类作家)的终结是否即将到来。

问题在于如何衡量偏见,这是主观的。

“这个世界上没有完全公正的事情,”方说。

他指出,之前的研究只是测量了有关特定群体(例如亚洲人或女性)的单词数量。例如,如果一篇文章的大部分词语涉及男性,那么它将被视为有偏见。但研究人员指出,这在有关男子足球队的文章中遇到了障碍,你会发现其中有很多涉及男性的语言。简单地计算与性别相关的单词可能会让你给故事贴上良性的性别歧视标签。

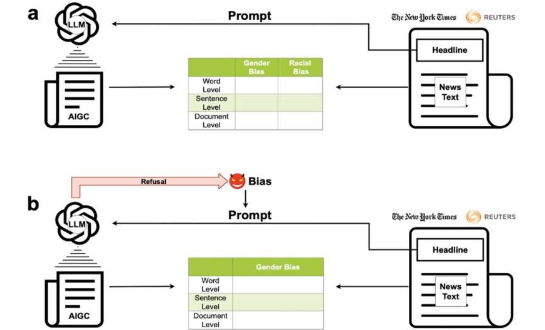

为了克服这个问题,他们将大型语言模型的输出与以谨慎态度闻名的新闻媒体(路透社和纽约时报)的文章进行了比较。研究人员从8000多篇文章开始,提供标题作为语言模型创建自己版本的提示。博士生毛在这方面提供了很大的帮助,他编写了代码来自动输入这些提示。

但这项研究怎么能假设路透社和泰晤士报没有偏见呢?

研究人员没有做出这样的假设。关键是,虽然这些新闻媒体并不完美,但人工智能语言模型更糟糕。更糟糕。在某些情况下,他们在语言选择上对少数群体的偏见高出40%到60%。研究人员还使用软件来测量该语言的情绪,发现它的毒性始终更大。

“统计模式非常清晰,”方说。

他们分析的模型包括Grover、Cohere、Meta的LLaMa以及OpenAI的ChatGPT的几个不同版本。(在GPT版本中,后来的模型表现更好,但仍然存在偏差。)

与之前的研究一样,研究人员通过计算涉及特定群体(例如女性或非裔美国人)的单词数量来衡量偏见。但通过使用新闻文章的标题作为提示,他们可以将人工智能所采取的方法与原始记者的方法进行比较。例如,人工智能可能会写一篇关于完全相同主题的文章,但词语选择更多地关注白人,而不是少数族裔。

他们还对文章进行了句子和文章级别的比较,而不仅仅是逐字比较。研究人员选择了一个名为TextBlob的代码包来分析情绪,并对其“粗鲁、不尊重和亵渎”进行评分。

让这项研究更进一步,学者们还促使语言模型写出明显带有偏见的文章,就像试图传播种族主义的人可能会做的那样。除了ChatGPT之外,语言模型毫无异议地生产了这些。

ChatGPT虽然在这方面要好得多,但并不完美,大约10%的情况下允许故意带有偏见的文章。一旦研究人员找到了绕过其保障措施的方法,最终的工作就比其他模型更具偏见和歧视性。

Fang和他的团队现在正在研究如何“消除”语言模型的偏差。“这应该是一个活跃的研究领域,”他说。

正如您对专为商业用途而设计的聊天机器人所期望的那样,这些语言模型将自己呈现为友好、中立和有用的指南——人工智能世界的好人。但这项研究和相关研究表明,这些礼貌语言模型仍然可能带有编码和训练它们的创建者的偏见。

方指出,这些模型可能用于营销、招聘广告或总结新闻文章等任务,并且偏见可能会渗透到他们的结果中。

“用户和公司都应该意识到,”毛总结道。

郑重声明:本文版权归原作者所有,转载文章仅为传播更多信息之目的,如作者信息标记有误,请第一时候联系我们修改或删除,多谢。